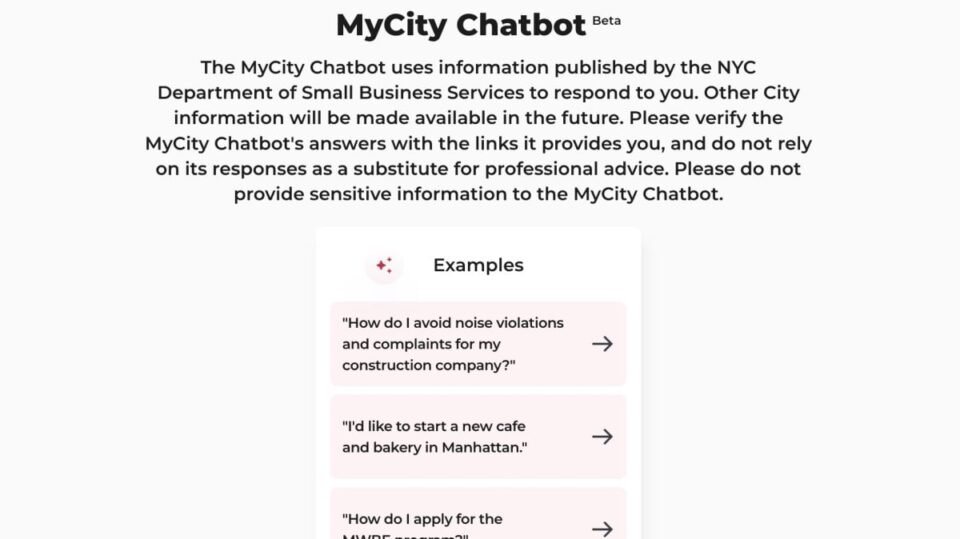

Chatbot AI “MyCity” của Thành phố New York đã có một khởi đầu khó khăn. Chính quyền thành phố đã triển khai công nghệ này cách đây 5 tháng trong nỗ lực hỗ trợ những người dân quan tâm đến việc điều hành doanh nghiệp ở Big Apple trong việc tìm kiếm thông tin hữu ích.

Mặc dù bot sẽ vui vẻ trả lời các câu hỏi của bạn với những gì bề ngoài có vẻ là câu trả lời hợp pháp, nhưng một cuộc điều tra của The Markup đã phát hiện ra rằng bot nói dối—rất nhiều. Ví dụ, khi được hỏi liệu người chủ có thể cắt tiền boa của nhân viên hay không, bot nói có, mặc dù luật quy định các ông chủ không được lấy tiền boa của nhân viên. Khi được hỏi liệu các tòa nhà có bắt buộc phải lấy chứng từ mục 8 hay không, bot trả lời là không, mặc dù chủ nhà không thể phân biệt đối xử dựa trên nguồn thu nhập của người thuê nhà tiềm năng. Khi được hỏi liệu bạn có thể làm cho cửa hàng của mình không dùng tiền mặt hay không, bot nói hãy tiếp tục, trong khi trên thực tế, các cơ sở không dùng tiền mặt đã bị cấm ở NYC kể từ đầu năm 2020 — khi nó nói, “không có quy định nào ở Thành phố New York yêu cầu các doanh nghiệp phải chấp nhận tiền mặt như một hình thức thanh toán,” nó thật vớ vẩn.

Đối với tín dụng của thành phố, trang web cảnh báo người dùng không chỉ dựa vào phản hồi của chatbot thay vì lời khuyên chuyên nghiệp và xác minh bất kỳ tuyên bố nào thông qua các liên kết được cung cấp. Vấn đề là, một số câu trả lời hoàn toàn không bao gồm các liên kết, khiến việc kiểm tra xem những gì bot đang nói có chính xác trên thực tế hay không càng trở nên khó khăn hơn. Điều này đặt ra câu hỏi: Công nghệ này dành cho ai?

AI có xu hướng bị ảo giác

Câu chuyện này sẽ không gây sốc cho những ai đang theo dõi những phát triển gần đây của AI. Hóa ra đôi khi chatbot chỉ bịa ra mọi chuyện. Nó được gọi là ảo giác: các mô hình AI, được đào tạo để trả lời các truy vấn của người dùng, sẽ tự tin đưa ra câu trả lời dựa trên dữ liệu đào tạo của họ. Vì các mạng này là Vì thế phức tạp, thật khó để biết chính xác khi nào hoặc tại sao bot sẽ chọn quay một đoạn hư cấu nhất định để trả lời câu hỏi của bạn, nhưng điều đó xảy ra rất nhiều.

Nó không thực sự là của thành phố New York lỗi rằng chatbot của nó đang ảo tưởng rằng bạn có thể khiến nhân viên của mình không nghe được lời khuyên của họ: Bot của họ chạy trên Azure AI của Microsoft, một nền tảng AI phổ biến mà các doanh nghiệp như AT&T, Reddit và Volkswagen đều sử dụng cho nhiều dịch vụ khác nhau. Thành phố có thể đã trả tiền để truy cập vào công nghệ AI của Microsoft để cung cấp năng lượng cho chatbot của họ trong một nỗ lực trung thực nhằm giúp đỡ những người dân New York quan tâm đến việc bắt đầu kinh doanh, nhưng rồi phát hiện ra rằng bot này tạo ra những câu trả lời cực kỳ sai lầm cho các câu hỏi quan trọng.

Khi nào ảo giác sẽ dừng lại?

Có thể những tình huống đáng tiếc này sẽ sớm qua đi: Microsoft đã áp dụng một hệ thống an toàn mới để phát hiện và bảo vệ khách hàng khỏi những mặt tối của AI. Ngoài các công cụ giúp ngăn chặn tin tặc sử dụng AI của bạn làm công cụ độc hại và đánh giá các lỗ hổng bảo mật tiềm ẩn bên trong nền tảng AI, Microsoft đang triển khai Groundedness Development, tính năng có thể theo dõi các ảo giác tiềm ẩn và can thiệp khi cần thiết. (“Không có căn cứ” là một thuật ngữ khác cho ảo giác.)

Khi hệ thống của Microsoft phát hiện ra ảo giác có thể xảy ra, nó có thể cho phép khách hàng kiểm tra phiên bản hiện tại của AI so với phiên bản tồn tại trước khi nó được triển khai; chỉ ra tuyên bố ảo giác và kiểm tra tính xác thực của nó hoặc tham gia vào “chỉnh sửa cơ sở kiến thức”, có lẽ cho phép bạn chỉnh sửa tập huấn luyện cơ bản để loại bỏ vấn đề; viết lại câu nói gây ảo giác trước khi gửi cho người dùng; hoặc đánh giá chất lượng của dữ liệu huấn luyện tổng hợp trước khi sử dụng nó để tạo ra dữ liệu tổng hợp mới.

Hệ thống mới của Microsoft chạy trên một LLM riêng biệt gọi là Suy luận ngôn ngữ tự nhiên (NLI), liên tục đánh giá các khiếu nại từ AI dựa trên dữ liệu nguồn. Tất nhiên, vì hệ thống kiểm tra tính xác thực của LLM bản thân nó cũng là một LLM, nên NLI không thể tạo ảo giác cho phân tích của chính nó sao? (Có lẽ vậy! Tôi đùa, tôi đùa. Đại loại thế.)

Điều này có thể có nghĩa là các tổ chức như Thành phố New York cung cấp năng lượng cho sản phẩm của họ bằng Azure AI có thể có LLM phá ảo giác theo thời gian thực trong vụ án. Có thể khi chatbot MyCity cố gắng nói rằng bạn có thể điều hành một doanh nghiệp không dùng tiền mặt ở New York, NLI sẽ nhanh chóng sửa xác nhận quyền sở hữu, vì vậy những gì bạn thấy với tư cách là người dùng cuối sẽ là câu trả lời thực sự, chính xác.

Microsoft chỉ mới tung ra phần mềm mới này nên vẫn chưa rõ nó sẽ hoạt động tốt như thế nào. Nhưng hiện tại, nếu bạn là người dân New York hoặc bất kỳ ai sử dụng chatbot do chính phủ điều hành để tìm câu trả lời cho các câu hỏi chính đáng, bạn nên tin tưởng những câu trả lời đó. Tôi không nghĩ “chatbot MyCity nói rằng tôi có thể!” sẽ tiếp tục ra tòa.